Was wir bei der Vorführung von Googles neuer Tiefen-API gelernt haben

Machen Sie sich bereit für ein Upgrade: Anfang Dezember enthüllte Google seine Depth API, eine neue Funktion für ARCore, die es ermöglicht, dass virtuelle Objekte und reale Umgebungen besser zusammenspielen, was zu überzeugenderen und immersiveren Mixed-Reality-Erlebnissen führt. Eine nachweisbare Art und Weise, wie die Depth API dies erreicht, ist die Ermöglichung von Okklusion, also der Illusion, dass virtuelle Objekte von realen Objekten verdeckt werden.

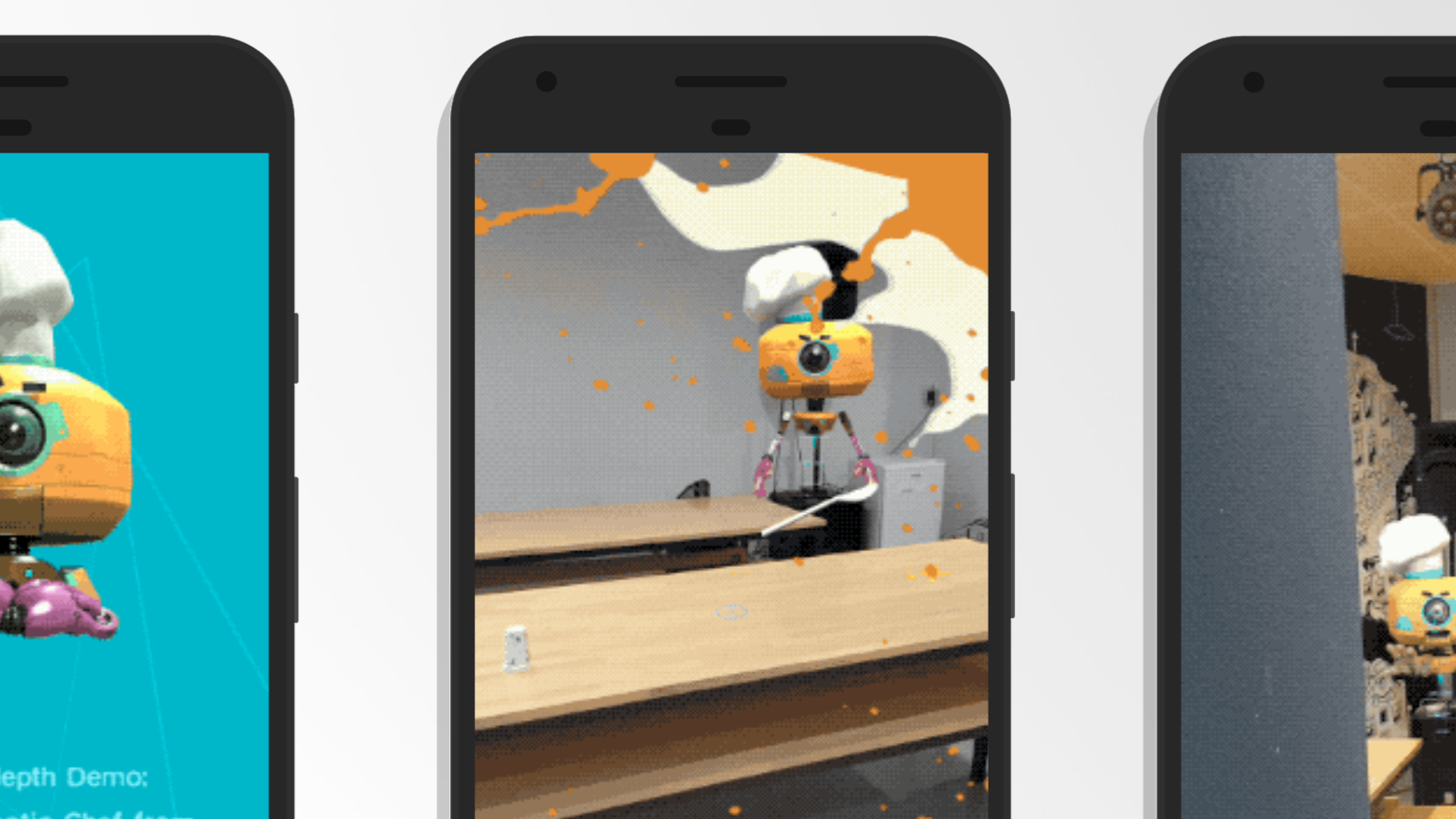

Eine überzeugende Okklusion war in der Vergangenheit nur schwer zu erreichen. Google hat jedoch ein Video mit Demos der neuen API zusammengestellt, in dem die Funktionen vorgestellt werden. Eine dieser Demos, die den Benutzer zu einer virtuellen Essensschlacht gegen einen schwebenden Roboterkoch herausfordert, wurde in Zusammenarbeit mit MediaMonks entwickelt.

Das Spannende an der Tiefen-API ist ihre Fähigkeit, die Umgebung des Benutzers mit einer noch nie dagewesenen Geschwindigkeit und Leichtigkeit zu erfassen. "Die Tiefenkarte der API wird in Echtzeit aktualisiert, so dass AR-Apps Oberflächen ohne komplexe Scanschritte erkennen können", sagt Samuel Snider-Held, Creative Technologist bei MediaMonks. Dies ermöglicht nicht nur die oben erwähnte Okklusion, sondern auch die Nachahmung von Echtzeit-Physik. Bei unserer virtuellen Essensschlacht gegen den AR-gerenderten Roboter ist das Vermissen Teil des Spaßes; die Benutzer können sich an den digitalen Essensspritzern auf den Objekten um sie herum erfreuen, ohne sich Gedanken über die Reinigung zu machen.

Die Bausteine für mehr immersive AR

Wie funktioniert die Depth API, und was unterscheidet sie von anderen Methoden der Okklusion? "Die Depth API verwendet einen Ansatz namens 'Tiefe aus Bewegung', bei dem ARCore die Abstände zu Objekten durch die Erkennung von Abweichungen zwischen Bildframes bestimmt, während sich die Kamera bewegt", sagt Snider-Held. "Das Ergebnis ist eine hochauflösende Tiefenkarte, die in Echtzeit aktualisiert wird und es dem Gerät ermöglicht, besser zu verstehen, wo sich Objekte im Verhältnis zueinander befinden und wie weit sie vom Nutzer entfernt sind."

Die Tiefen-API ist softwarebasiert und erfordert keine neue Hardware für Nutzer mit ARCore-fähigen Geräten, sobald sie veröffentlicht wird. Während eine ausreichende Okklusion die Realitätsnähe von virtuellen Objekten deutlich erhöht, folgt sie einer Reihe von inkrementellen Updates, die aufeinander aufbauen, um realistischere immersive Erfahrungen zu ermöglichen. Erst letztes Jahr - im selben Jahr, in dem ARCore debütierte - veröffentlichte Google seine Lighting Estimation API, die virtuelle Objekte so beleuchtet, dass sie den Lichtverhältnissen in der realen Umgebung entsprechen, einschließlich Lichtreflexionen, Schatten, Schattierungen und mehr.

Seitdem ermöglicht eine Funktion namens Cloud Anchors mehreren Nutzern, dieselben virtuellen Objekte zu sehen, die in einer bestimmten Umgebung verankert sind. Es ist die Schlüsselfunktion für den Mehrspielermodus von Pharos AR, einem Augmented-Reality-Erlebnis, das wir in Zusammenarbeit mit Childish Gambino, Wolf + Rothstein, Google und Unity entwickelt haben - und das selbst als De-facto-Demo dafür diente, wozu Cloud Anchors in der Lage sind, um völlig neue Mixed-Reality-Erlebnisse zu aktivieren.

"Wir haben das kreative und technische Know-how, um diese neuen Technologien zu nutzen und zu verstehen, warum sie wichtig und großartig sind", sagt Snider-Held. "Wir haben keine Angst vor Technologien, die noch in den Kinderschuhen stecken, und können sie mit der Unterstützung unseres Kreativteams in kürzester Zeit umsetzen."

Ein optimierter Weg zur Abbildung von Tiefe

Die Depth API war nicht das erste Mal, dass MediaMonks mit Okklusion oder räumlicher Wahrnehmung in der erweiterten Realität experimentierte. Zuvor haben wir bereits mit anderen modernen Lösungen für Okklusion experimentiert, wie z. B. 6D.ai, das ein unsichtbares 3D-Netz einer Umgebung erstellt. Das Ergebnis dieser Methode ähnelt dem, was mit Depth API erreicht wird, aber die Ausführung ist anders; die Übersetzung einer Umgebung in ein 3D-Netz mit 6D.ai geht am schnellsten mit mehreren Kameras, während Depth API einfach die Tiefe in Echtzeit misst, ohne dass eine ganze Umgebung gescannt und rekonstruiert werden muss.

In ähnlicher Weise ermöglichte Tango - Googles Skunkworks-Projekt, das eine Art Vorläufer von ARCore war - eine spezielle Wahrnehmung durch Punktwolken. "Als wir Tango von früher hatten, verwendete es etwas Ähnliches wie einen Kinect-Tiefensensor", sagt Snider-Held. "Man würde die Punktwolken nehmen, die man davon erhält, und die Tiefe rekonstruieren, aber die neue Tiefen-API verwendet nur eine einzige Kamera."

Wir haben keine Angst davor, uns mit Technologien zu befassen, die noch in den Kinderschuhen stecken, und wir können sie mit der Unterstützung unseres Kreativteams schnell umsetzen.

Das Erreichen von Okklusion mit einer einzigen Kamera, die die Umgebung in Echtzeit scannt, bedeutet einen großen Sprung in der Benutzerfreundlichkeit und macht es für die Benutzer auf ihren aktuellen Mobilgeräten weithin verfügbar. "Wenn wir es schaffen, die Umgebung richtig zu verdecken, fühlt es sich mehr nach der realen Welt an. Die Art und Weise, wie sie es machen, ist interessant, mit einer einzigen Kamera", sagt Snider-Held.

Mehr Tiefe für kreative Erlebnisse

Die Depth API ist derzeit für Einladungen zur Zusammenarbeit offen und noch nicht bereit für eine öffentliche Veröffentlichung, aber sie ist ein großer Schritt, um glaubhaftere Szenen in Echtzeit zu rendern. "Es ist ein weiterer Schritt auf dem Weg zu den Arten von AR-Erlebnissen, die wir uns vorstellen", sagt Snider-Held. "Wir können diese Projekte ohne Vorbehalte durchführen."

Eine ständige Herausforderung beim Rendering von AR-Szenen ist zum Beispiel, dass viele Nutzer einfach nicht über ausreichend große Wohnräume verfügen, um große Objekte oder ausgedehnte virtuelle Räume zu rendern. Kreativteams können dieses Problem umgehen, indem sie Objekte in Miniaturformat rendern - vielleicht nur auf einer Tischplatte. "Mit der Depth API können wir festlegen, dass nur Objekte innerhalb des verfügbaren Raums gerendert werden", sagt Snider-Held. "Das gibt uns und unseren Kunden ein besseres Gefühl bei der Gestaltung dieser immersiven Erlebnisse

Während Marken sich überlegen, wie sie einige der neuesten Funktionen der sich schnell entwickelnden Mixed-Reality-Technologie nutzen können, profitieren sie von Kreativ- und Produktionspartnern, die Ideen einbringen und sie schnell und mit dem Bewusstsein für die aktuellen Möglichkeiten und Herausforderungen umsetzen können. "Wir bringen kreatives Denken in die Technologie ein, mit dem, was wir aufgrund unserer technischen Expertise tun können, aber auch mit Dingen wie Konzeptkunst, Animation und mehr", sagt Snider-Held. "Wir schrecken nicht vor neuen Technologien zurück, und wir verstehen sie nicht nur, sondern können auch etwas wirklich Lustiges und Originelles schaffen, um zu zeigen, warum die Leute sie haben wollen."

Verwandte

Themen

-

![A portrait of a woman in profile, facing right, with her blonde hair blurred as if in motion. She wears a black turtleneck against a dark, moody background featuring abstract magenta and purple rectangles and vertical lines. Her face is illuminated, while the rest of the image has a blurred, dreamlike quality.]()

Blog-Beitrag

Was 2025 über KI enthüllt wurde und was 2026 möglich sein wird Von Monks 5 min Lesezeit -

![A pale pink "New message" window with thin black outlines floats against a pastel gradient background of lavender, pink, and peach. Inside the window are "To" and "Subject" fields, and a rounded rectangular "Send" button in the bottom right corner. The window has a simple close "X" icon in the top right.]()

Blog-Beitrag

Aufbau von Vertrauen in den E-Mail-Posteingang und einer starken Absenderreputation durch disziplinierte Warming-Strategien Von Bridget Creach 9 min Lesezeit -

![search]()

Blog-Beitrag

Die Antwort Engine Battles: Navigieren durch die ChatGPT-Anzeigeneinführung Von Tory Lariar 4 min Lesezeit

Schärfen Sie Ihre Kanten in einer Welt, die nicht warten will

Melden Sie sich an, um E-Mail-Updates mit umsetzbaren Erkenntnissen, aktuellen Forschungsergebnissen und bewährten Strategien zu erhalten.

Monks benötigt die Kontaktinformationen, die Sie uns zur Verfügung stellen, um Sie über unsere Produkte und Dienstleistungen zu informieren. Sie können sich jederzeit von diesen Mitteilungen abmelden. Informationen darüber, wie Sie sich abmelden können, sowie über unsere Datenschutzpraktiken und unsere Verpflichtung zum Schutz Ihrer Daten finden Sie in unserer Datenschutzrichtlinie.