Tus métricas mienten: Cómo gestionar el impacto del tráfico de bots en tus datos

Se estima que alrededor del 40% de todo el tráfico en internet es generado por bots, según Statista. Esto es especialmente relevante para quienes integramos la industria del marketing y el análisis de datos, ya que la presencia de este tráfico puede distorsionar reportes y llevarnos a tomar como válidas métricas contaminadas, muchas veces sin siquiera darnos cuenta. Con los datos, ya es bastante difícil asegurarse de que todo se esté recopilando correctamente; pero con los bots, ¿cómo se pueden obtener insights reales?

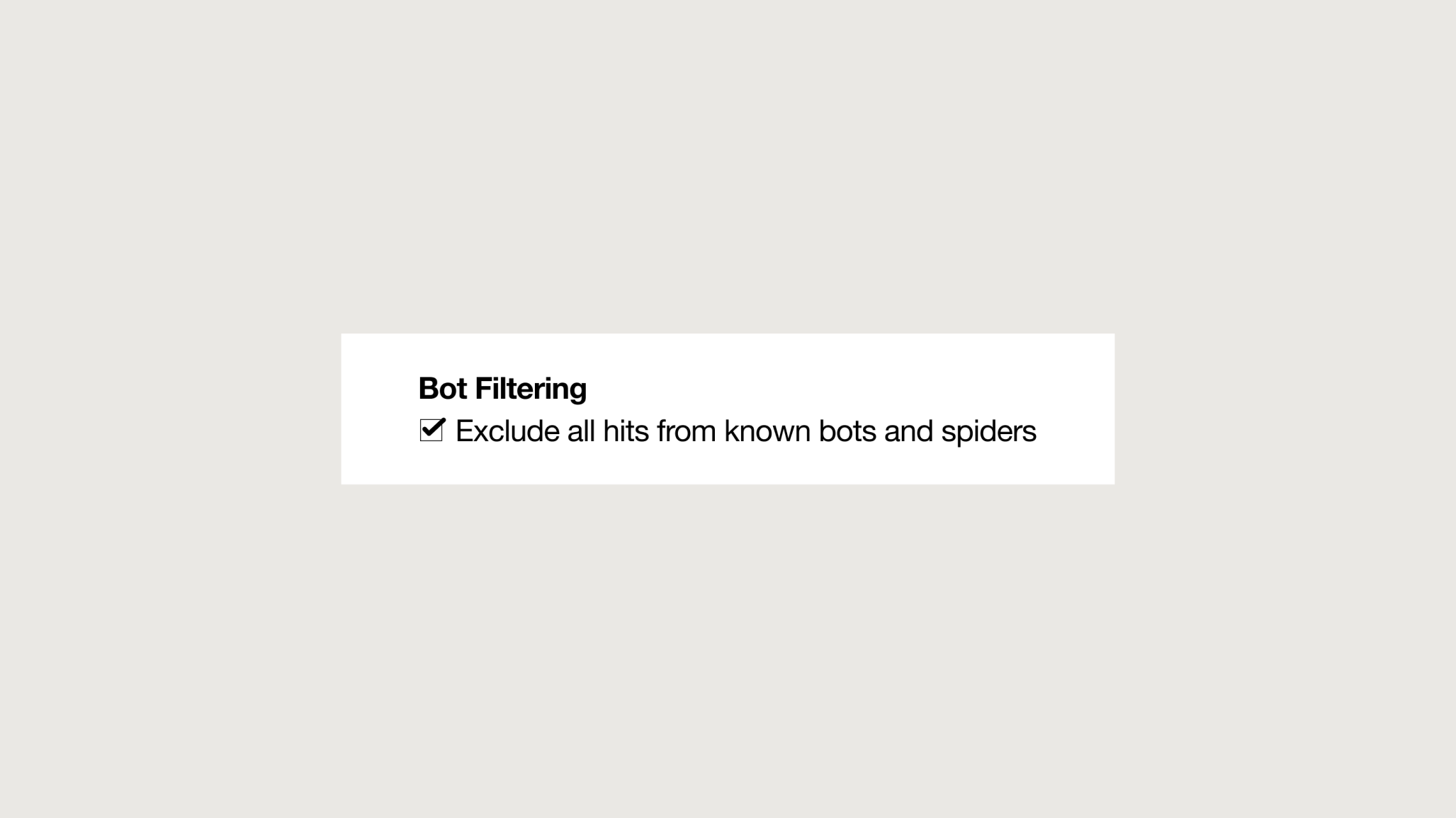

Como respuesta a este problema, las herramientas de analítica digital más populares en el mercado han incorporado funcionalidades para filtrado de bots. Si bien es recomendable activarlas, han demostrado una efectividad muy baja frente a los diferentes tipos de bots que abundan en la red.

En resumen, nuestros datos están en peligro.

¿Cuáles son los impactos comerciales del tráfico de bots?

En el caso de empresas que toman decisiones de negocios basadas en datos, el tráfico de bots tiene consecuencias perjudiciales para sus estrategias digitales, ya que impacta en diversas métricas como la tasa de conversión, tasa de rebote, total de usuarios y sesiones, generando variaciones sin una explicación clara. Además, el aumento del tráfico puede incrementar los costos en herramientas de análisis digital que suelen basar sus modelos de costos en el número de visitas. Las herramientas de inteligencia artificial y las implementaciones que se entrenan con datos afectados por bots de tráfico pueden producir percepciones inexactas.

El tráfico de bots también puede reducir la velocidad y la seguridad en sitios web al sobrecargar los servidores, lo que resulta en cargas lentas de las páginas o, en casos graves, inaccesibilidad general para los usuarios. En casos extremos, permitir tráfico no deseado en un sitio puede incurrir en vulnerabilidades de seguridad y filtraciones de información sensible.

Recientemente, uno de nuestros clientes nos solicitó asistencia para revisar ciertos aumentos repentinos de tráfico provenientes de Frankfurt durante las horas de madrugada, lo cual no concordaba con sus datos históricos. Después de analizar los reportes y cruzar las distintas dimensiones disponibles, descubrimos que, en ciertos períodos, el 90% de los usuarios totales que registraban los reportes mostraban un comportamiento difícil de atribuir a humanos. sto no solo afectaba gravemente la calidad de los datos, sino que también generaba un gran gasto debido a la cantidad de visitas que recibía la web.

Sin embargo, no hace falta que la situación sea tan extrema para que la calidad de nuestros datos se vea afectada. Con un porcentaje mucho menor de comportamiento anómalo, ya podríamos hablar de informes poco confiables. Ahora bien, ¿cómo podemos prevenir esta situación y cuidar la calidad de nuestros datos?

Conocer al enemigo

El primer paso para contrarrestar a los bots es entenderlos. No todos los bots son iguales, y cada uno requerirá una estrategia diferente. Una de las clasificaciones más comunes es la distinción entre bots maliciosos y no maliciosos. Aquí veremos algunas variantes comunes de los maliciosos:

Tipos de bots maliciosos

1. Scalper bots:

Programas que realizan compras automatizadas y a gran velocidad en eventos con capacidad limitada, para luego revender bienes y servicios acaparados.

2. Spam bots:

Diseñados para habilitar o entregar spam. ¿Quién no ha recibido mensajes de correo o mensajería personal llenos de enlaces maliciosos?

3. Scraper bots:

Se dedican al web scraping, que implica la extracción automática de datos de páginas web. Estos programas capturan contenido web a gran escala. La intención suele ser copiar a los competidores y sacar ventaja con dicha información.

Por otro lado, los bots no maliciosos son aquellos que pueden realizar trabajos tediosos en un abrir y cerrar de ojos. Se encargan de recopilar grandes cantidades de datos que de otro modo tardarían días o incluso meses en recuperarse, aliviando la carga humana en tareas repetitivas.

Tipos de bots de tráfico beneficiosos

1. Spider (web crawler):

Los robots de Google son los más avanzados. Exploran constantemente Internet en busca de vídeos, imágenes, textos, enlaces y demás. Sin estos bots, los sitios no tendrían ni un solo visitante de la búsqueda orgánica.

2. Backlink checkers:

Estos programas permiten detectar todos los enlaces que un sitio web y una página obtienen de otros sitios web. Son una herramienta importante para SEO.

3. Bots de monitoreo de sitios web:

Estos robots vigilan los sitios web y pueden notificar al propietario cuando el sitio web está, por ejemplo, bajo ataque de piratas informáticos o cuando está fuera de línea.

No es mi intención detallar exhaustivamente los siempre cambiantes y dinámicos tipos de bots existentes, sino más bien resaltar que existen diferentes comportamientos que determinarán las estrategias y el nivel de dificultad de filtrado y eliminación en cada caso. A fin de cuentas, buenos o malos, todos los bots son indeseables para nuestros informes, y debemos trabajar para minimizar su impacto en nuestros datos.

Contrarrestar los ataques de bots con las herramientas correctas

Actualmente, en el mercado existen estrategias tanto automatizadas como no automatizadas para abordar este desafío. En el caso de las soluciones automatizadas, se destacan los programas de filtrado de bots, ya sea integrados en las herramientas de análisis o en software especializado en detección de bots impulsado por IA. Sin embargo, como mencionamos anteriormente, su eficacia suele ser baja, y en muchos casos conllevan costos asociados.

Por otro lado, contamos con soluciones no automatizadas que proveen mejores resultados, y podemos categorizarlas según el enfoque de filtrado que adoptan:

Enfoque reactivo: Aplica filtros personalizados a nivel reportes. Relativamente sencillo y flexible, no demanda modificaciones a nivel desarrollo. Es el primer paso para una detección temprana y efectiva. Utiliza herramientas disponibles en plataformas de analytics, como los segmentos GA4, filtros en Looker Studio y consultas en almacenes de datos. Es la opción más sencilla de implementar, aunque menos robusta.

Enfoque preventivo: Aplica filtros antes de la recolección de los datos. No es sencillo de implementar, requiere recursos de desarrollo. Incluye la colocación de filtros previos a la recolección de datos, lo impide el impacto tanto a nivel reportes como el ingreso de los bots a la web y sus servidores.

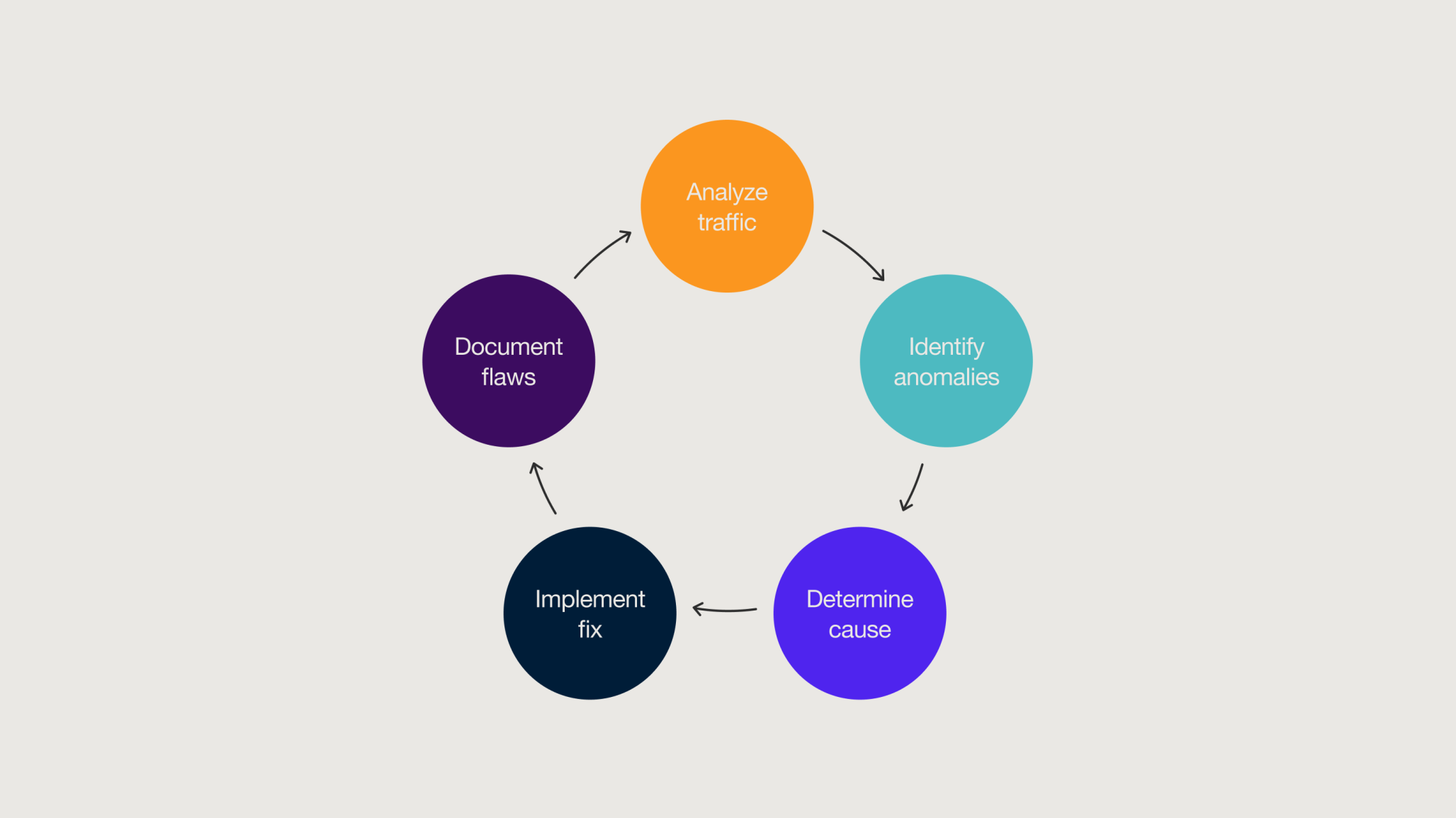

Establecer un ciclo de revisión de calidad de datos

Para lograr mantener nuestros datos libres de tráfico de bots y alcanzar resultados óptimos, es recomendable implementar una estrategia integral que combine enfoques preventivos y reactivos. Este es el denominado ciclo de revisión de calidad de datos, un modelo de vigilancia continua diseñado para detectar anomalías de manera constante. Consiste en un trabajo conjunto por parte de analistas, desarrolladores y product owners para encontrar soluciones eficientes que resguarden la integridad y fiabilidad de los datos.

A pesar de que no podemos garantizar la total eliminación del tráfico de bots en nuestros reportes, adoptar una actitud proactiva en la implementación de estrategias de revisión de calidad de datos nos brinda alternativas concretas y eficientes para enfrentar este desafío.

En resumen

- Los bots tienen propósitos maliciosos y no maliciosos; en ambos casos, es de interés mantener dicho tráfico fuera de los reportes.

- El tráfico de bots conlleva consecuencias negativas tanto a nivel de estrategia digital como comercial.

- Aunque las plataformas de analytics cuentan con funcionalidades que bloquean parte del tráfico de bots de forma automática, su efectividad es limitada.

- Es esencial monitorear constantemente anomalías en los informes para identificar el tráfico de bots.

- Para evitar la influencia de tráfico no deseado y asegurar que los datos no estén sesgados o contaminados, es necesario implementar medidas tanto preventivas como reactivas.

- La inclusión del ciclo de revisión de calidad de datos en el flujo de trabajo es fundamental para mantener los informes libres de tráfico de bots.

Related

Thinking

-

![Monks and Hightouch partner on CDP and AI]()

Entrada de blog

Monks y Hightouch forjan una nueva alianza para el marketing basado en datos y la IA en APAC Por Peter Luu 4 mins de lectura -

![A vibrant, flowing wave of translucent material reflecting colorful lights in shades of pink, blue, and purple. The background features a soft bokeh effect with blurred light sources, enhancing the ethereal and dynamic feel of the scene.]()

Entrada de blog

Consiga un marketing más inteligente con Salesforce Marketing Intelligence Por Ashley Musumeci 5 mins de lectura -

![Man using an electric sander]()

Entrada de blog

Obstáculos habituales para poner en marcha su programa de modelización de la combinación de marketing (MMM) Por Tim Fisher 3 mins de lectura

Aumenta tu ventaja en un mundo que no espera

Suscríbete para recibir actualizaciones por correo electrónico con información práctica, estudios de vanguardia y estrategias de eficacia probada.

Monks necesita la información de contacto que usted nos proporciona para ponerse en contacto con usted acerca de nuestros productos y servicios. Puede darse de baja de estas comunicaciones en cualquier momento. Para obtener información sobre cómo darse de baja, así como sobre nuestras prácticas de privacidad y nuestro compromiso con la protección de su privacidad, consulte nuestra Política de privacidad.