Suas métricas estão mentindo: Como gerenciar o impacto do tráfego de bots em seus dados

Estima-se que cerca de 40% de todo o tráfego da Internet seja gerado por bots, de acordo com o "Radar Report" da Cloudflare Para nós que trabalhamos com marketing e análise de dados, isso é um grande problema - o tráfego de bots pode distorcer nossos relatórios e nos levar a confiar em métricas imprecisas, muitas vezes sem que saibamos. Com os dados, já é difícil garantir que tudo esteja sendo coletado corretamente, mas com os bots de tráfego, como é possível obter insights reais?

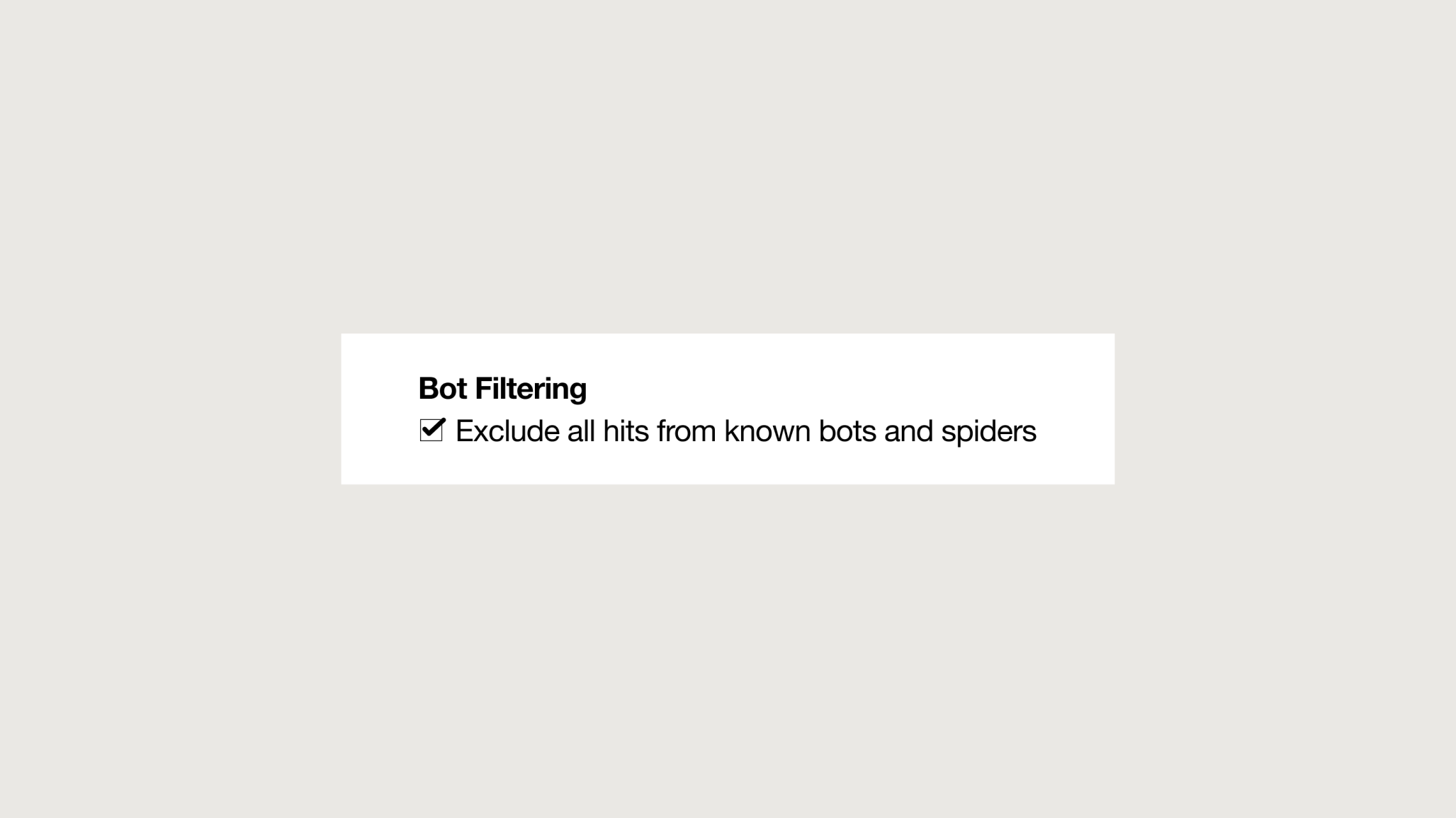

Como resposta a esse problema, as ferramentas de análise digital mais populares começaram a oferecer recursos de filtragem de bots. Embora seja aconselhável ativá-los, eles mostraram uma eficácia muito baixa contra os diferentes tipos de bots que abundam na Web ou, pior ainda, podem filtrar o tráfego real e benéfico de bots, distorcendo os dados em favor do tráfego impreciso.

Em resumo, nossos dados estão em risco.

Como o tráfego de bots afeta seus negócios?

Para as empresas que tomam decisões de negócios com base em dados, o tráfego de bots pode ter consequências prejudiciais em suas estratégias digitais. Ele distorce várias métricas, como taxas de conversão, taxas de rejeição, total de usuários e sessões, levando a flutuações inexplicáveis. Além disso, o aumento do tráfego pode aumentar os custos das ferramentas de análise digital, pois muitos modelos de preços são baseados no número de visitas. As ferramentas e implementações de IA que treinam em dados afetados por bots de tráfego podem produzir insights imprecisos. O tráfego de bots também pode prejudicar os sites ao sobrecarregar os servidores, resultando em tempos de carregamento de página lentos ou, em casos graves, tornando o site inacessível aos usuários. Em situações extremas, a permissão de tráfego indesejado pode criar vulnerabilidades de segurança e levar a vazamentos de informações confidenciais.

Recentemente, um de nossos clientes nos pediu ajuda para analisar alguns aumentos repentinos no tráfego originado de Frankfurt durante as primeiras horas da manhã, o que não estava de acordo com seus dados históricos. Depois de analisar os relatórios e cruzar as diferentes dimensões disponíveis, descobrimos que, durante determinados períodos, 90% do total de usuários registrados nos relatórios apresentavam um comportamento difícil de atribuir a seres humanos. Isso não apenas afetava seriamente a qualidade dos dados, mas também gerava despesas significativas devido ao volume de visitas que o site estava recebendo.

No entanto, não são apenas as situações extremas que podem afetar a qualidade de nossos dados. Até mesmo uma pequena porcentagem de anomalias pode levar a relatórios não confiáveis. Então, como podemos impedir isso e manter nossos dados confiáveis?

Conheça o inimigo

A primeira etapa para combater efetivamente os bots é entendê-los. Nem todos os bots são iguais; cada tipo exige uma estratégia exclusiva. Uma classificação comum distingue entre bots mal-intencionados e não mal-intencionados. Vamos examinar alguns exemplos típicos de bots mal-intencionados.

Tipos de bots de tráfego mal-intencionados

1. Scalper bots:

Esses programas adquirem ingressos e outros produtos de disponibilidade limitada na velocidade da luz, apenas para revendê-los posteriormente a preços mais altos.

2. Bots de spam:

Projetados para inundar sua caixa de entrada ou mensagens com lixo eletrônico, geralmente carregado com links maliciosos. Quem nunca foi vítima de um spam incômodo?

3. Bots raspadores:

Esses bots extraem automaticamente dados de sites, geralmente copiando conteúdo de concorrentes para obter vantagem.

Por outro lado, os bots não mal-intencionados são aqueles que podem lidar rapidamente com tarefas tediosas. Eles reúnem grandes quantidades de dados que, de outra forma, levariam dias ou até meses para serem recuperados, aliviando a carga dos humanos em tarefas repetitivas.

Tipos de bots de tráfego benéficos

1. Spider (rastreador da Web):

Os bots do Google são alguns dos mais avançados. Eles pesquisam incessantemente na Web vídeos, imagens, textos, links e muito mais. Sem esses rastreadores, os sites não receberiam nenhum tráfego de pesquisa orgânica.

2. Verificadores de backlinks:

Essas ferramentas ajudam você a encontrar todos os links que um site ou página recebe de outros sites. Elas são cruciais para o SEO.

3. Bots de monitoramento de sites:

Esses bots monitoram os sites e podem alertar o proprietário se, por exemplo, o site estiver sendo atacado por hackers ou ficar off-line.

Meu objetivo não é detalhar exaustivamente cada tipo de bot existente, pois eles estão em constante evolução. Em vez disso, quero destacar os vários comportamentos que influenciam nossas estratégias de filtragem e remoção, bem como a complexidade envolvida. No final, sejam eles bons ou ruins, todos os bots são indesejados em nossos relatórios e precisamos minimizar o impacto deles em nossos dados.

Combatendo ataques de bots com as ferramentas certas

Atualmente, você pode encontrar estratégias automatizadas e manuais para enfrentar esse desafio. No caso de soluções automatizadas, destacam-se os programas de filtragem de bots, integrados a ferramentas analíticas ou softwares especializados para detecção de bots orientada por IA. No entanto, como mencionado anteriormente, sua eficácia tende a ser baixa e, em muitos casos, eles vêm com custos associados.

Por outro lado, temos soluções não automatizadas que fornecem melhores resultados e podemos categorizá-las com base na abordagem de filtragem que adotam:

Abordagem reativa: Aplicar filtros personalizados no nível do relatório. Esse método é simples e flexível, não exigindo alterações no nível de desenvolvimento. É uma primeira etapa eficaz para a detecção precoce. A utilização de ferramentas disponíveis em plataformas de análise - como segmentos do GA4, filtros do Looker Studio e consultas ao data warehouse - facilita a implementação, embora seja menos robusta.

Abordagem preventiva: Implemente filtros antes de coletar dados. Embora isso possa ser desafiador e exigir muitos recursos, evita efetivamente o impacto nos relatórios e impede que os bots acessem o site e seus servidores.

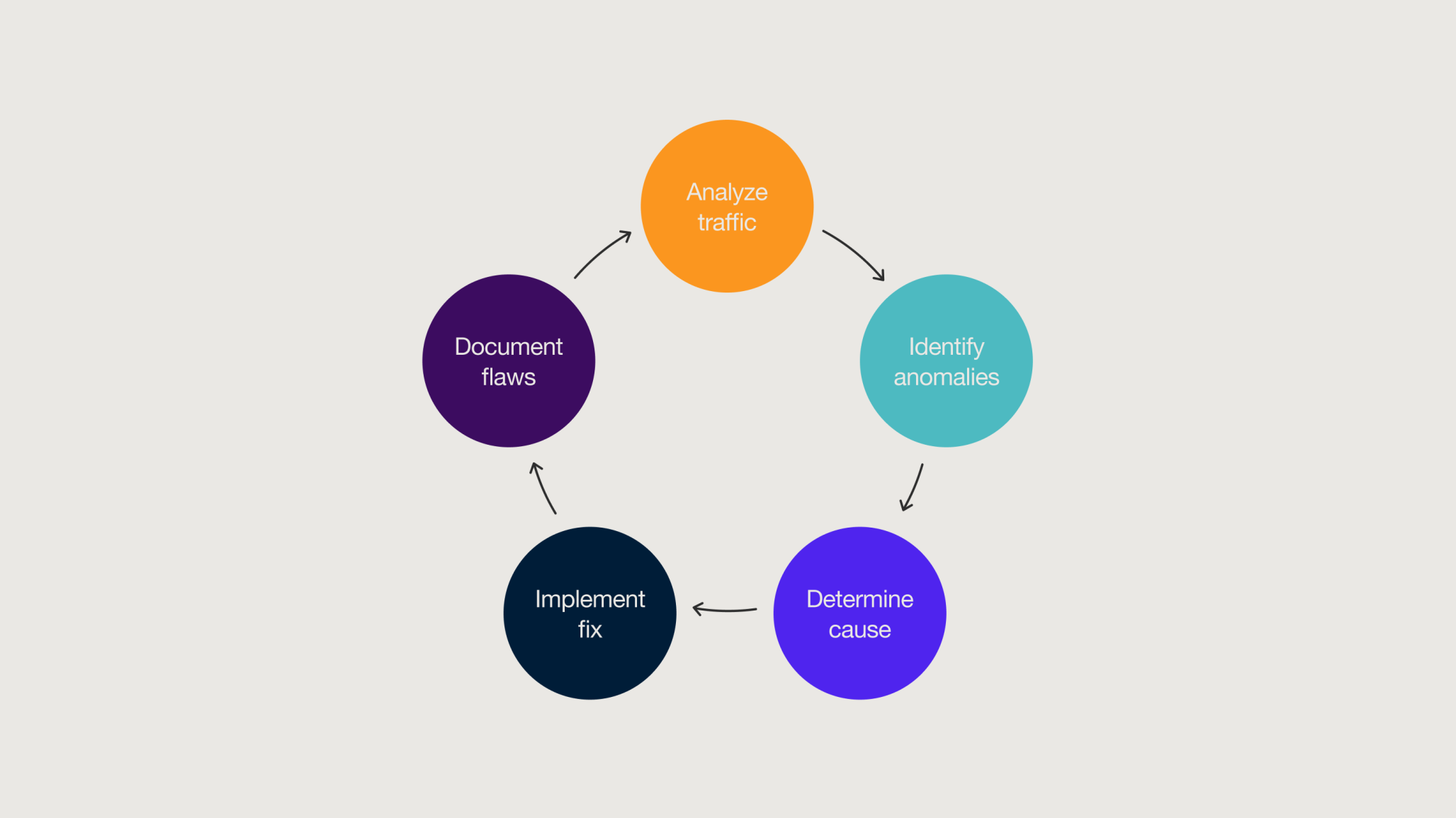

Estabelecimento de um ciclo de revisão da qualidade dos dados

Para manter nossos dados livres de tráfego de bots e garantir resultados ideais, é melhor usar uma estratégia abrangente que combine medidas preventivas e reativas. Isso é conhecido como ciclo de revisão da qualidade dos dados, um modelo de monitoramento contínuo projetado para detectar anomalias constantemente. Ele envolve esforços colaborativos de analistas, desenvolvedores e proprietários de produtos para encontrar soluções eficientes que protejam a integridade e a confiabilidade dos dados.

Embora não seja possível eliminar totalmente o tráfego de bots de nossos relatórios, a implementação proativa de estratégias de revisão da qualidade dos dados nos oferece maneiras práticas e eficazes de resolver esse problema.

Em resumo

- Os bots podem servir tanto para fins prejudiciais quanto para fins benignos, portanto, é fundamental mantê-los fora dos relatórios.

- O tráfego de bots tem consequências negativas para as estratégias digitais e comerciais.

- Embora as plataformas de análise tenham recursos que bloqueiam automaticamente parte do tráfego de bots, sua eficácia é limitada.

- O monitoramento constante de anomalias nos relatórios é essencial para identificar o tráfego de bots.

- Para evitar a influência indesejada do tráfego e garantir que os dados não sejam tendenciosos ou contaminados, é necessário implementar medidas preventivas e reativas.

- A inclusão de um ciclo de revisão da qualidade dos dados no fluxo de trabalho é fundamental para manter os relatórios livres de tráfego de bots.

Conteúdos Relacionados

-

![Monks and Hightouch partner on CDP and AI]()

Publicação no blog

Monks e Hightouch formam uma nova parceria para marketing orientado por dados e IA na APAC Por Peter Luu 4 minutos de leitura -

![A vibrant, flowing wave of translucent material reflecting colorful lights in shades of pink, blue, and purple. The background features a soft bokeh effect with blurred light sources, enhancing the ethereal and dynamic feel of the scene.]()

Publicação no blog

Obtenha um marketing mais inteligente com o Salesforce Marketing Intelligence Por Ashley Musumeci 5 minutos de leitura -

![Man using an electric sander]()

Publicação no blog

Obstáculos comuns para colocar seu programa de modelagem do mix de marketing (MMM) em funcionamento Por Tim Fisher 3 minutos de leitura

Faça nosso coração digital bater mais rápido

Receba nosso boletim informativo com insights acionáveis sobre as últimas tendências, projetos e muito mais.

A Monks precisa das informações de contato que você nos fornece para entrar em contato com você sobre nossos produtos e serviços. Você pode cancelar a assinatura dessas comunicações a qualquer momento. Para obter informações sobre como cancelar a assinatura, bem como sobre nossas práticas de privacidade e nosso compromisso com a proteção de sua privacidade, consulte nossa Política de Privacidade.